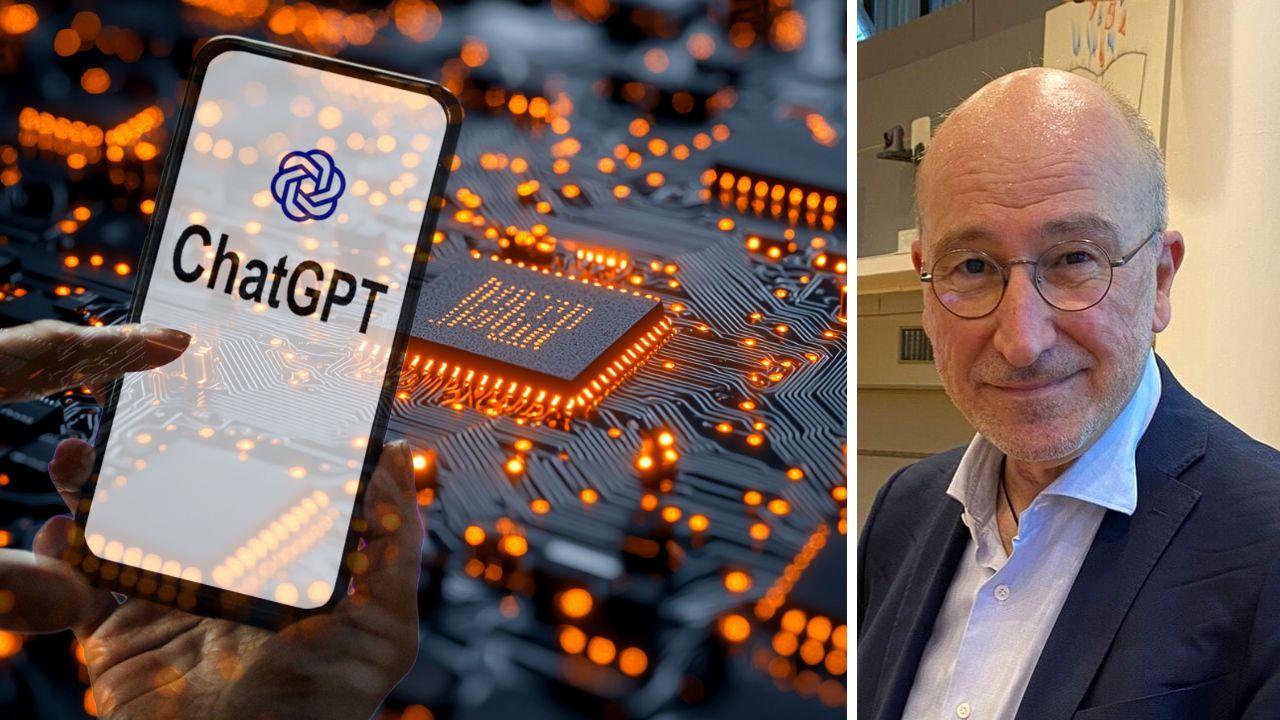

Chatbot e IA, un corso gratuito all’Università di Pisa: «Tutti a scuola per “domare” i robot amici-nemici»

Il professor Adriano Fabris: «L’etica delle tecnologie pone problemi globali a cui devono essere date risposte globali, non variabili da Stato a Stato»

PISA. C’è chi la usa per fare le ricerche a scuola e chi le chiede consiglio (e conforto) perché la fidanzata l’ha lasciato, chi la interroga per sapere cosa cucinare per cena. L’interlocutore così versatile si chiama chatGpt o Copilot o Gemini... l’assistente IA o chatbot che utilizza l’intelligenza artificiale conversazionale.

Basta digitare una parola su google o fare una domanda ad Alexa e l’IA si mette in moto. L’utilizzo dell’intelligenza artificiale si è diffuso rapidamente a tutti i livelli, più o meno (in) consapevoli. E le previsioni stimano uno sviluppo massivo per i prossimi due anni. Non è più e solo materia per informatici, aziende e “iniziati”. Ma quanto ne sappiamo di IA e soprattutto dei risvolti del suo utilizzo? Che necessariamente pone anche una questione normativa e soprattutto etica. Per questo l’Università di Pisa ha attivato un corso online gratuito, aperto a tutti, dal titolo “Etica dell’intelligenza artificiale” che è disponibile sulla piattaforma nazionale Edvance e si rivolge a studenti e studentesse, professionisti e professioniste e in generale a tutte quelle persone interessate ad acquisire competenze critiche e consapevoli sull’uso delle tecnologie intelligenti.

Il corso è tenuto dal professor Adriano Fabris, ordinario di Filosofia Morale all’Università di Pisa, dove insegna anche Etica e Deontologia dell’IA. Fabris è direttore del Centro Interdisciplinare di Ricerche e Servizi sulla Comunicazione; è presidente della Consulta Nazionale di Filosofia (Italia) e membro del Consiglio di amministrazione della Fondazione Golinelli. Tra le sue numerose pubblicazioni, le più recenti sono: “Digital Environments and Human Relations” (2024) , “Insegnare con l’intelligenza artificiale” (2025 con L. Perla) e “La filosofia nell’epoca dell’intelligenza artificiale” (2025).

Professore, partiamo dalle basi: perché c’è bisogno di un’etica dell’IA? E che cosa significa? E soprattutto che rischi corriamo?

«La parola intelligenza artificiale ha un suono evocativo, fa pensare a cose che non sono reali, a programmi e macchine che pensano come gli esseri umani, in realtà imitano alcuni aspetti del pensiero umano. Il modello è sempre l’essere umano, si tratta di programmi che agiscono con una certa autonomia, che possono imitare le cose più ripetitive e procedurali ma non hanno la duttilità dell’originale».

Ci può fare un esempio?

«L’intelligenza artificiale può imitare una sinfonia di Mozart ma le manca la creatività. Non riuscirebbe a ricreare una sinfonia originale secondo i canoni dell’epoca di Mozart. Perché i programmi hanno un certo grado di autonomia ma obbediscono a determinate procedure».

Questo cosa comporta?

«Si parla di etica dei programmi, perché per la prima volta nella storia dell’umanità programmi e macchine hanno un certo grado di autonomia fuori dal costante controllo umano. Programmi che possono imparare dall’interazione con l’ambiente all’interno di contesti e situazioni specifiche. Sfuggono dunque per la prima volta al nostro controllo completo. Che facciamo, smettiamo di sviluppare questi programmi e macchine? Non è possibile, l’essere umano migliora e progredisce con le invenzioni. Dobbiamo quindi conoscere e interagire con questi nuovi programmi e nuove macchine, trovando regole e limiti affinché non diventino dannosi per l’essere umano. È questa l’etica delle tecnologie. Per l’intelligenza artificiale servono principi condivisi».

Come si può trovare una norma universale?

«A livello normativo ci sono centinaia di codici deontologici, il mio gruppo di ricerca all’università di Pisa ne ha censiti 200 per Stati o associazioni, ma valgono solo al loro interno. “AI Act”, la norma Ue del 2024 vale solo in Europa e non negli USA, ma l’etica delle tecnologie pone problemi globali a cui devono essere date risposte globali con principi e criteri che riguardano l’essere umano come tale, non variabili da categorie o Stati».

Quali sono questi criteri?

«Il rispetto della privacy, l’equità nell’accesso alle risorse dell’intelligenza artificiale, la responsabilità nell’uso dei programmi e dei dispositivi, l’attenzione alla condivisione dei risultati positivi che ne derivano. L’intelligenza artificiale deve essere sviluppata per servire allo sviluppo degli esseri umani, per questo si parla di human centered IA. Dobbiamo evitare gli effetti negativi, in primo luogo la sostituzione, il deskilling. È un po’ come la casiera del supermercato che usando sempre la calcolatrice non riesce più a fare le operazioni aritmetiche, o lo studente che facendo le ricerche su chatGpt non riesce più a scrivere un testo in italiano corretto. In altre parole si rischia di diventare servi dei nostri servitori».

In questo contesto, professore, si può dire che la cultura e la formazione sono fondamentali, anzi sempre più indispensabili?

«Esatto. Bisogna educare alla IA. Insegnanti, studenti, giornalisti... devono sapere cosa sta dietro a programmi e dispositivi, che sembra facile usare ma spesso non abbiamo chiare le conseguenze di questo utilizzo. Le faccio un esempio: se uso chatGpt devo imparare le query cioè le domande giuste da porre, altrimenti sono un fruitore cieco e non ottengo le risposte che vorrei. Queste chat, questi chatbot vogliono essere usati e danno sempre ragione al richiedente per tenerlo agganciato e prendere i suoi dati in modo da migliorare le proprie prestazioni».

Che cosa fa la scuola per formare i futuri cittadini fruitori della Ia?

«Già nei nuovi programmi approvati durante la pausa natalizia ci sono indicazioni che riguardano il primo ciclo di istruzione, in cui dovrà essere introdotto un corso di informatica di base per un avvicinamento all’utilizzo dell’intelligenza artificiale, per capire che un’azione nel mondo virtuale ha conseguenze nel mondo reale spesso inimmaginate. Nei licei è già previsto uno spazio nei programmi di educazione civica, finalizzato all’educazione alla cittadinanza digitale».

C’è un rapporto, e di che tipo, tra intelligenza artificiale e social?

«C’è uno stretto legame tra i social e l’utilizzo della IA, ad esempio lo scrolling compulsivo. Chiediamoci come funziona l’algoritmo di un social. Prende i nostri dati, che vengono selezionati e utilizzati dall’intelligenza artificiale. C’è poi un problema di costi, a cui non pensiamo mai. Quando noi facciamo una domanda ad Alexa o a Gemini, magari una domanda banale come chiedere cosa posso cucinare per cena, questo comporta l’uso di risorse energetiche enormi, l’utilizzo di risorse d’acqua di una famiglia per una settimana».

L’etica delle tecnologie ha un capitolo specifico per le aziende, di cui si parla da tempo. A che punto siamo?

«Le aziende devono seguire dei protocolli specifici, ci sono regolamenti e normative, ma anche in questo caso variano da Stati a Stati. Per esempio nell’Unione europea ci sono regole anche troppo attente, lo ha detto lo stesso Mario Draghi, che possono porre un freno all’innovazione. Norme che vietano l’uso dell’intelligenza artificiale nell’addestramento e garantiscono la tutela dei dati sensibili, tutto viene tracciato. Norme che prevedono investimenti notevoli. Negli USA invece Trump, appena eletto, ha eliminato il decreto Biden del 2023 che regolamentava l’utilizzo della IA. Questo crea problemi di concorrenza ma non si può inseguire la strada della deregulation. Diversi stati americani hanno legiferato per regolamentare l’uso della IA, in assenza di regole generali».

Prevede una ulteriore diffusione dell’uso della IA a breve?

«Penso che questo sviluppo non si possa fermare, un ultimo passaggio riguarda l’intelligenza artificiale capace di comunicare. In realtà è un’illusione: chatGpt fa discorsi sensati ma solo dal punto di vista sintattico, non ha collegamenti con il mondo reale. Adesso c’è l’intelligenza artificiale generale, già applicata, che avrà un’ulteriore diffusione nei prossimi 1 – 2 anni. Sono programmi e macchine che possono prendere decisioni al posto nostro. Già succede: gli aerei decollano e atterrano in modo automatizzato. Sono applicazioni anche molto importanti e positive per la nostra vita. Per esempio sotto il controllo del chirurgo ci sono macchinari che interagiscono in tempi rapidissimi senza aspettare il nostro intervento. Ovviamente non hanno l’intuito dell’essere umano, né l’esperienza a cui noi spesso facciamo riferimento. Qual è il rischio? La sostituzione dell’essere umano. Per questo dobbiamo conoscere i programmi e le macchine e il loro utilizzo».

E torniamo alla formazione.

«Esattamente, è importante la sensibilizzazione di ciò che avviene. Se mi convinco che il programma ha empatia chiedo a chatGpt un consiglio se la fidanzata mi ha lasciato, ma è solo una proiezione della realtà ed è falsa. Invece se sappiamo usare bene questi programmi possiamo avere vantaggi enormi, ma il corretto uso va conosciuto da tutti i possibili utilizzatori, per questo insegnanti e docenti di tutti gli ordini di scuola devono essere formati e preparati».